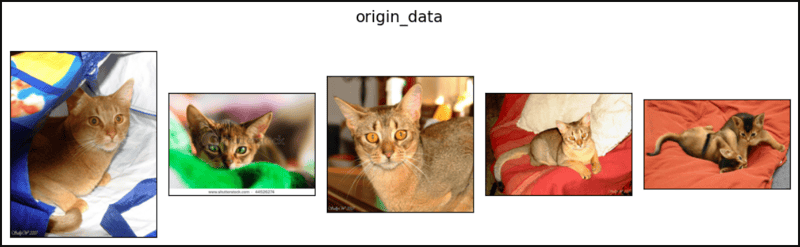

PyTorch的transforms.Compose为何CPU利用率可超过100%

在使用PyTorch的transforms.Compose进行图像预处理时,监控工具显示CPU利用率可能超过100%,例如达到116%-117%。这引发了一个疑问:Python拥有全局解释器锁(GIL),理论上应该限制单线程的CPU利用率不超过100%,为什么会出现这种情况?

问题的核心在于transforms.Compose的底层实现。虽然用户代码是用Python编写的,但transforms.Compose以及其中用到的transforms.Resize、transforms.CenterCrop、transforms.ToTensor和transforms.Normalize等变换函数,其核心计算部分并非完全由Python实现。PyTorch为了性能优化,大量使用了C/C++编写的高效代码。这些C/C++代码不受Python的GIL限制。

当执行transforms.Compose时,Python代码负责调度和组织各个变换步骤,但实际的图像处理操作(例如缩放、裁剪、归一化等)则由底层的C/C++代码执行。这些C/C++代码可以并行执行或充分利用多核CPU,从而导致整体CPU利用率超过100%。这并非意味着程序消耗了超过100%的CPU计算能力,而是监控工具显示的是所有CPU核心的利用率总和,而不仅仅是单个核心的利用率。

对比一下提供的等效Python代码,该代码完全用Python实现图像预处理的各个步骤。由于受GIL限制,其CPU利用率无法超过100%。这进一步佐证了PyTorch利用C/C++实现高性能计算,从而突破GIL限制的结论。 因此,即使监控工具显示CPU利用率超过100%,也并不意味着程序存在问题,而是PyTorch底层高效实现的结果。